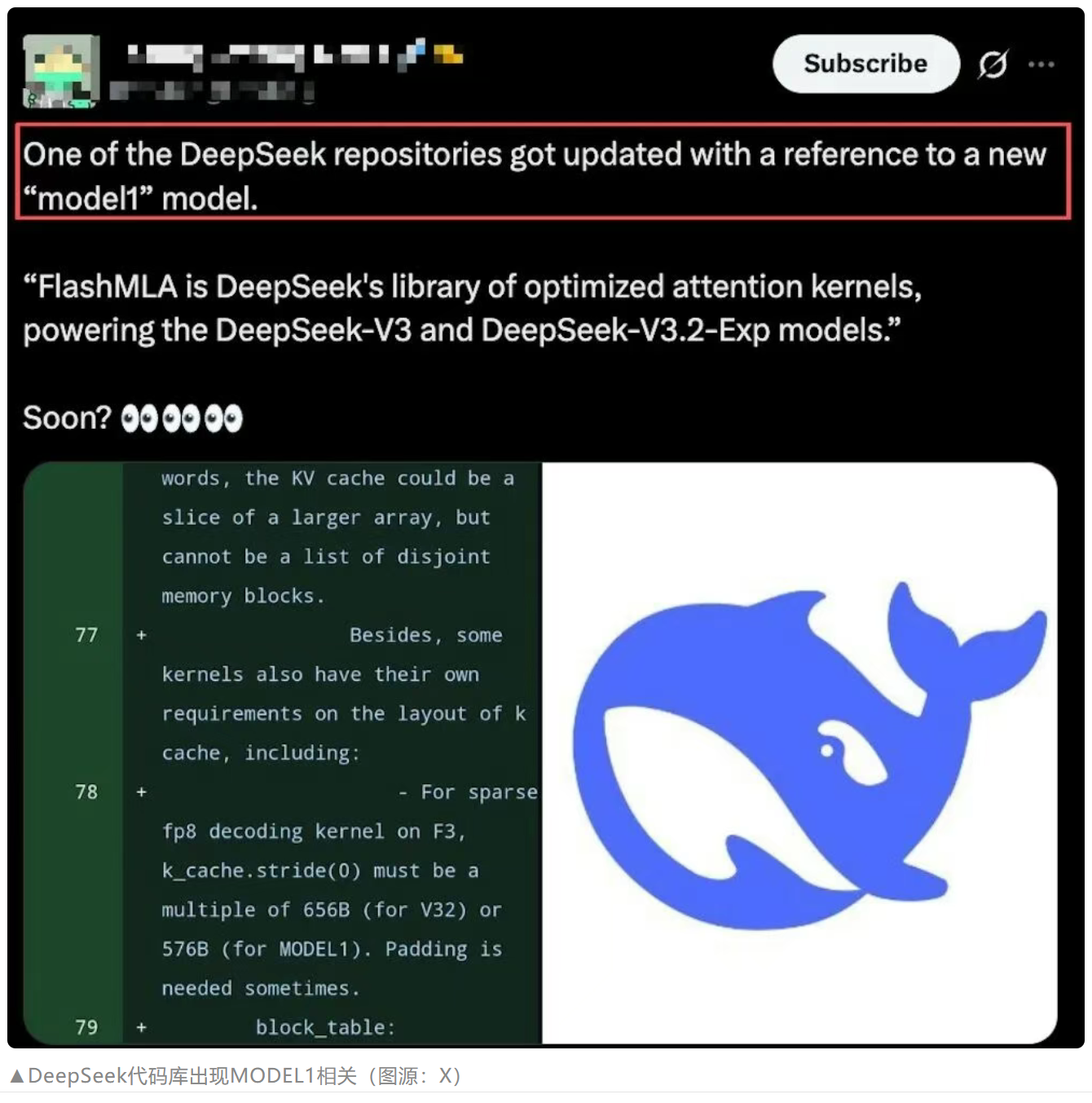

代码证据:FlashMLA 中的 MODEL1

来自 FlashMLA 源代码库的直接证据,展示 MODEL1 的实现。

ModelType::MODEL1 引用

直接代码引用显示 MODEL1 是一个具有专用实现路径的独特模型类型。

持久化内核文件结构

MODEL1 持久化内核文件与 V3.2 版本并行存在,表明独立的编译路径。

内存对齐注释

代码注释揭示了 MODEL1 KV 缓存的 576B 步长要求(后从代码库中删除)。